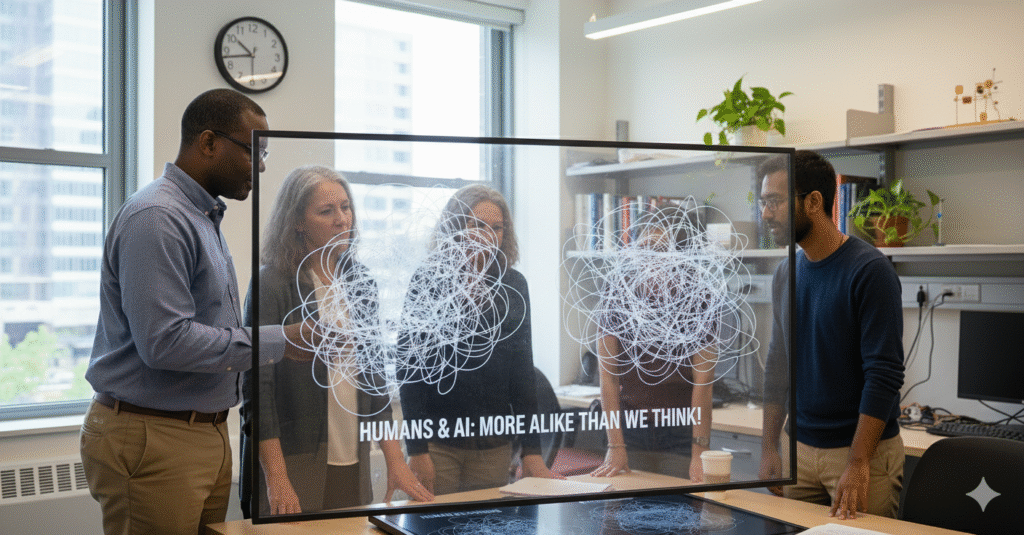

Un nuevo estudio de la Universidad de Brown muestra que, aunque las inteligencias artificiales no “piensan”, su forma de resolver problemas se parece más a la humana de lo que muchos creían.

Cuando una persona enfrenta un problema lógico sencillo, rara vez se sienta a demostrar teoremas en su cabeza. No sigue pasos formales, no enumera axiomas. Más bien prueba ideas, descarta opciones, se guía por intuiciones rápidas y asociaciones vagas. Avanza como puede.

Los modelos modernos de inteligencia artificial hacen algo parecido. No porque entiendan el problema, sino porque han aprendido estadísticamente qué rutas suelen llevar a respuestas aceptables.

Eso es exactamente lo que acaba de mostrar un equipo de investigadores de Brown University: cuando se observa el proceso de razonamiento —no solo la respuesta final— humanos y modelos de lenguaje siguen patrones sorprendentemente similares.

No es que las máquinas piensen. Es que, visto desde fuera, no razonan tan distinto. No pensamos tan lógicamente como creemos

Durante décadas, la psicología cognitiva ha mostrado algo incómodo: los humanos no somos máquinas de lógica. Usamos atajos mentales, heurísticas, conjeturas rápidas. A veces funcionan. A veces no.

El nuevo estudio de Brown parte de esa idea y hace una comparación directa: pone a humanos y a modelos de lenguaje a resolver tareas donde deben descubrir reglas ocultas, ajustar hipótesis y corregirse con base en retroalimentación.

El resultado es desconcertante por lo simple: las trayectorias de razonamiento se parecen. Ambos exploran posibilidades, se atascan en ideas plausibles pero incorrectas, y solo gradualmente ajustan su “modelo” del problema. No hay deducción limpia. Hay tanteo.

Qué hacen igual humanos y modelos de lenguaje

Una de las observaciones clave del estudio es que ni las personas ni las IA siguen estrategias óptimas desde el inicio. Ambos: se aferran a hipótesis iniciales aunque empiecen a fallar, ajustan creencias poco a poco, no de golpe, muestran sesgos hacia explicaciones simples aunque no siempre sean correctas.

Esto contradice la idea popular de que las IA “calculan todo” mientras los humanos improvisan. En realidad, ambos improvisan, solo que por razones distintas.

Los humanos lo hacen por limitaciones cognitivas. Las IA lo hacen porque aprendieron patrones de éxito en enormes cantidades de datos. El resultado externo se parece más de lo que nos gusta admitir.

Entonces… ¿la IA razona como nosotros? No. Y aquí está el matiz importante.

Los investigadores son claros: los modelos de lenguaje no entienden, no tienen intenciones, no saben que están razonando. Lo que ocurre es que su entrenamiento los lleva a producir secuencias de pasos que, vistas desde fuera, imitan el comportamiento humano.

Dicho sin romanticismo: la IA no razona como un humano, pero razona parecido. Y eso basta para que nos confundamos. Lo que sí sabemos / lo que no Lo que sí sabemos

Humanos e IA muestran patrones de razonamiento similares en ciertas tareas. Ambos usan estrategias no formales, basadas en exploración gradual. La similitud aparece en el proceso, no solo en el resultado.

Lo que no sabemos (y el estudio no afirma) Que la IA tenga comprensión real. Que “piense” o sea consciente. Que estos resultados se extiendan a todo tipo de razonamiento complejo. Por qué este resultado importa Porque desmonta dos mitos a la vez.

El primero: que los humanos razonamos de forma impecable y lógica. No lo hacemos. Nunca lo hemos hecho.

El segundo: que las IA son radicalmente distintas en todo sentido. En muchos niveles internos sí lo son, pero el comportamiento observable converge.

Esto tiene implicaciones prácticas: explica por qué confiamos demasiado en respuestas de IA bien redactadas, por qué a veces nos parecen “sensatas” incluso cuando están equivocadas, y por qué distinguir intuición humana de estadística sofisticada se vuelve cada vez más difícil.

El riesgo no es que la IA piense. Es que nosotros lo creamos. El hallazgo de Brown no humaniza a las máquinas. Nos desmitifica a nosotros.

Nos recuerda que buena parte de lo que llamamos “razonar” es, en realidad, navegar la incertidumbre con herramientas imperfectas. Herramientas que ahora las máquinas también imitan con sorprendente eficacia.

La diferencia sigue siendo fundamental:

cuando un humano se equivoca, puede entender por qué.

cuando una IA acierta, no sabe que acertó.

Confundir esas dos cosas no es un error técnico. Es un error conceptual. Y esos suelen ser los más caros.